Pour continuer de convaincre les détracteurs ici présent que:

- que pour faire un campus AI gigantesque dépassant le GW, le concept de "mise à l'échelle" fonctionne, qu'il

suffit de mettre plus d'argent sur la table, beaucoup plus d'argent (ordre de grandeur 10 milliards de dollar pour ce premier campus Stargate), de construire des datacenter plus grand, et d'en construire plus

- que le refroidissement par dry cooler est totalement faisable sur de telles puissances (l'industrie le sait depuis longtemps, mais bon...), donc sans consommation massive d'eau qu'on ferait évaporer

- que ce genre d'infrastructure ne craint pas forcément les fortes chaleurs vu que ce campus est au Texas, région chaude et assez pauvre en eau.

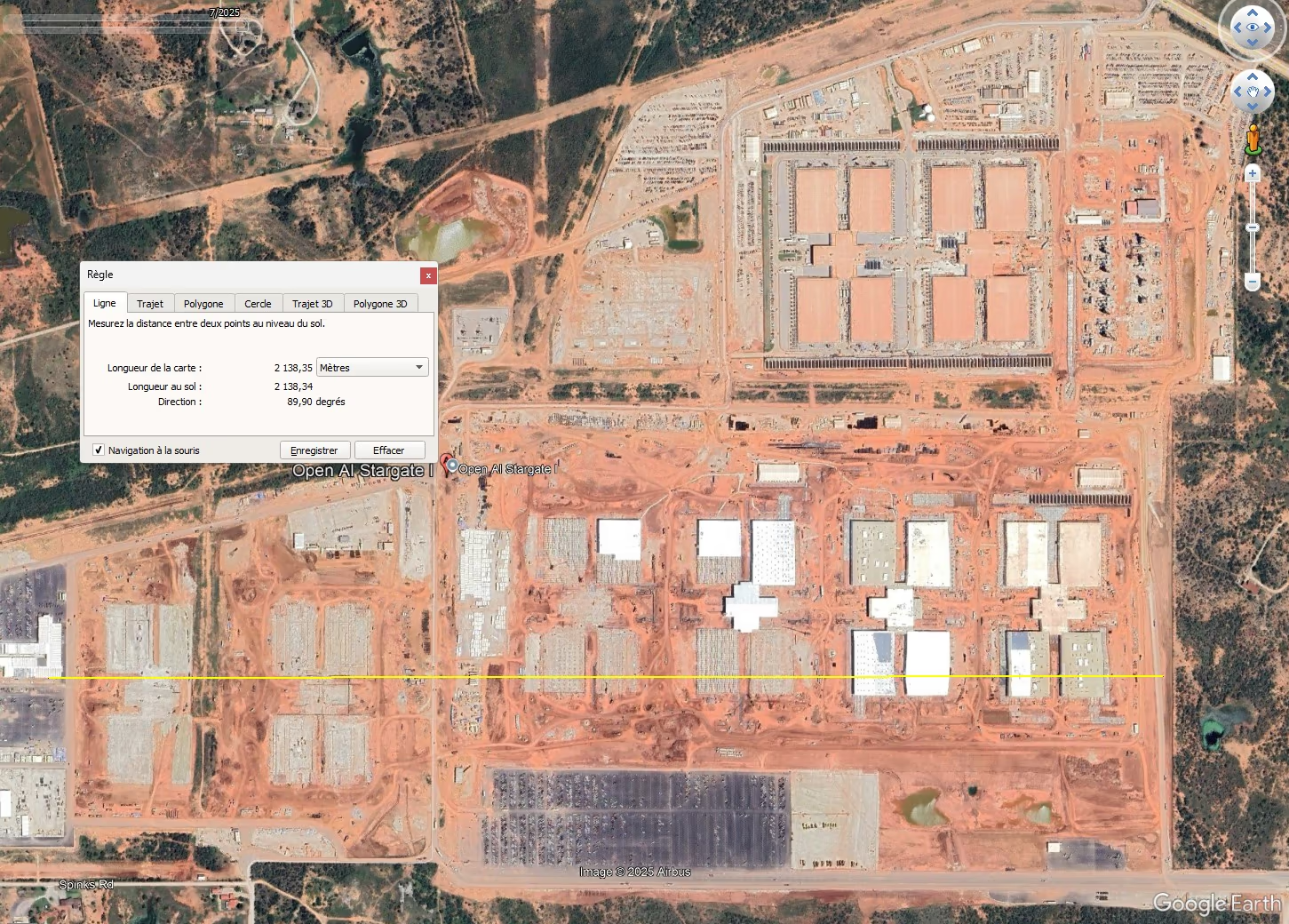

Voici le site Stargate-1 de Open-AI, dans la ville d'Abilène au Texas.

Cible 1.2GW au total pour ce campus, déjà réservés côté réseau électrique.

Le campus de 170 hectares abritera 8 datacenters géants, tous les 8 sont en cours de construction.

Chacun de ces datacenter géants est équipé de 90 dry coolers de bonne taille. Donc 720 dry coolers au total, ce qui explique bien le concept de mise à l'échelle que certains ici ont du mal à comprendre (je ne sais pas trop pourquoi).

Sur place, ils construisent aussi une centrale électrique constituée de 10 turbines à gaz industrielles pour le secours de l'alimentation électrique.

Après, est-ce que tout ça est utile et bénéfique pour notre société? La question est pertinente évidemment; je n'ai pas d'avis tranché. Ma démonstration ci dessus porte juste sur l'aspect "industriel" de ces datacenters, leur faisabilité, rien de plus.

Leon.