Quelques news du cluster:

J'ai enfin eu le temps de compiler les modules noyau bnx2x de support de la carte BMC57810S, sur le premier nœud, qui ping en dessous du 0,1 ms, comme il se doit en 10Gbps, que la commande lspci confirme.

L'objectif, c'est de placer une carte BMC57810S dans chaque nœud, afin d'améliorer la vitesse d'interconnexion de la grappe cephfs, ainsi que la latence d'accès. Le cluster étant la dernière partie noble de mon réseau local encore en 1Gbps.

Je rappelle l'organisation du cluster:

- Noeud N°1 - une vieille machine 4770S intel sur CM Asus H97P-plus, qui est là depuis 7 ans presque (Oct 2014, et oui, comme le temps passe) - le port PCI-E sort du PCIe 3.0 en x16.

La compilation, l'activation du module, les interfaces, tout se passe bien.

- Nœud N°2 - Récemment mis à jour, avec un processeur AMD Ryzen 7 PRO 4750G sur une carte mère Asrock B550 Pro4. Là, par chance, on a deux ports PCIE, Gen3x16+Gen3x4, et l'on peut cumuler 2 cartes BMC57810S dessus. Je vais y revenir plus loin.

- Nœud N°3 - un i7 6700K sur une Asus Z170i Pro Gaming - Attention, c'est une carte micro ATX, avec un seul port PCIE, en 3.0 x16. Ce noeud dispose déjà d'une carte BMC5810s, sur laquelle est façonné le pont logique avec en entrée l'ONU SFP paramétré pour synchroniser mon accès fibre en HSGMII 2.5Gbps, et une sortie en SFP+ 10Gbps

Problème N°1 - Le nœud N°3, actuellement utilisé pour le pont, ne peut actuellement accueillir de nouvelle carte PCIe, car il n'y a qu'un seul port PCIe. Cette carte dual SFP+ étant en amont de l'authentification par le routeur, on ne peut pas communiquer avec le réseau local. Pour la garder à sa place je devrais éventuellement donc changer la carte mère pour une carte de plus grande dimension à chipset Z170 (attention, le matériel va bientôt sur ses 5 ou 6 ans... Les I7 6700K et chipset Z170 ont été lancés au Q3 2015).

Solution N°1 On dégrade le nœud N°3 au rang de simple nœud, et on dédie sa carte BMC57810s à la seule connexion au réseau local en 10GGbps. Parallèlement, je place 2 cartes BMC dual SFP+ sur le nœud N°2, une pour le pont, une autre pour la connexion 10Gbps au réseau local.

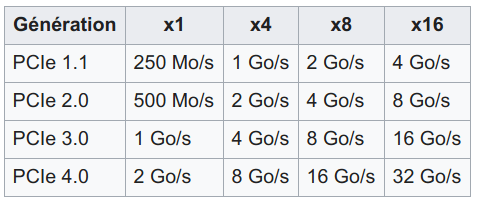

Problème N°2 Le Ryzen 7 PRO 4750G est un processeur de la génération renoir, et selon la documentation, "AMD Ryzen series APUs (Renoir) • 2 x PCI Express x16 Slots (PCIE1: Gen3x16 mode; PCIE3: Gen3 x4 mode)" Donc, un premier port en PCIE 3.0 x8, et le second en x4... J'entends bien que, selon la norme, du PCIE x4 permet une bande passante de 4Go/s soit 32Gb/s. Le tableau que j'affiche plus haut, souvent cité en exemple, indique des vitesses théoriques. En passant d'un Matisse Ryzen 7 3700X à un Renoir, ça passe de Gen4x16+Gen3x4 à Gen3x16+Gen3x4. En récupérant le slot de la carte video, je libérais un port PCIE, mais au prix d'une perte en vitesse sur les ports.

Solution N°2 Je vais procéder à des essais avec le matériel à disposition. Le débit brut du port PCIE secondaire devrait suffire largement pour le pont, et de même sur le principal pour l'interconnexion 10Gbps. J'essaierai dans un sens et dans l'autre, pour voir si j'ai un intérêt à utiliser une option plutôt que l'autre.

Je ne sais pas si je suis bien clair, mais placer deux cartes BMC57810s sur les 2 ports PCIE d'une carte ASROCK B550 Pro4, avec un processeur Ryzen 7 Pro 4750G de génération Renoir en Zen2 7nm, poussent le stress des lignes PCIe au point de relire deux fois qu'il s'agit bien de Go/s et non de Gb/s...

Nous verrons bien. J'attends des risers de qualité, car sur les 3 dont je dispose, 2 se sont abîmés, rendant les essais infructueux.

Stay tuned.